Analiza jakości strony jest kluczem do naprawienia problemów, zwiększenia liczby odwiedzin i poprawienia sprzedaży. Przedstawiamy zestaw narzędzi online, które powinien znać każdy webmaster.

Według zasady Pareto do osiągnięcia 80% zysku wystarczy 20% środków. Problem w tym, jak je znaleźć. Bez wątpienia przydadzą się przedstawione przez nas narzędzia online, które przetestują stronę pod każdym względem i zapewnią dane do analizy. Dzięki nim znajdziesz miejsca, które powinieneś zoptymalizować, a strona odniesie jeszcze większy sukces.

1. Google Analytics

Jeśli chcemy zmierzyć zachowanie użytkowników strony, to nic nie zastąpi Google Analytics. O tych statystykach pisaliśmy wielokrotnie. GA dostarczają kompleksowych informacji o aktualnym i przeszłym ruchu i pozwalają dostosować witrynę do internautów. Większość z nich pochodzi z Wielkopolski? Umieszczajmy więcej newsów Z Poznania. Użytkownicy IE kupują mniej niż pozostali? Może formularz zamówienia nie działa poprawnie?

Tak było w przypadku jednego z brytyjskich sklepów internetowych. Internauci korzystający z IE byli witani ostrzeżeniem bezpieczeństwa, gdy tylko chcieli przejść na stronę płatności. W efekcie bali się o swoje bezpieczeństwo, zamykali przeglądarkę i kupowali pięciokrotnie mniej niż pozostali. Dzięki statystykom udało się ustalić stronę, na której użytkownicy IE przerywają transakcję i powiększyć sprzedaż o ponad 30000 funtów rocznie!

Jest tylko jedno „ale”: ostrzeżenie wyskakiwało z powodu źle zainstalowanych… statystyk Google. Samo narzędzie nie wystarczy – potrzebna jest jeszcze osoba, która potrafi je obsłużyć.

2. Browsershots.org

Każdy projektant chciałby, żeby jego strona wyświetlała się poprawnie u wszystkich użytkowników. Zamiast instalować kilka systemów operacyjnych i kilkanaście przeglądarek w różnych wersjach w celu przyjrzenia się witrynie, warto skorzystać z Browsershots.org. To narzędzie wykona zrzuty ekranu naszej strony w ponad 60 konfiguracjach uwzględniających popularne systemy i przeglądarki, również w nieaktualnych, ale ciągle używanych wersjach.

Oprócz przeglądarki możemy wybrać {link_wew 780}rozdzielczość ekranu{/link_wew}, oraz określić czy mają być obsługiwane Flash, Javascript i Java.

Niestety wykonanie zrzutów trwa od kilku do kilkunastu minut, a wyniki dostępne są tylko przez pół godziny. W wersji płatnej ($29,95 albo 22,95 euro) te ograniczenia zostały zdjęte.

3. Raven

Bardzo rozbudowanym narzędziem jest Raven Internet Marketing Tools. Pierwszy miesiąc korzystania jest darmowy. Później kosztuje $19 – $1499 w zależności od liczby użytkowników i analizowanych stron i służy do kompleksowego monitoringu sieci.

Za jego pomocą dowiemy się, jak strona wypada na tle konkurencji i co należy poprawić. Co tydzień lub co miesiąc otrzymamy dane zebrane w kompleksowym raporcie o stronie. Niestety narzędzie trzeba skonfigurować ręcznie, bo automatyczne wyszukiwanie słów kluczowych i konkurencji do monitoringu działa po prostu źle. Zarówno słowa kluczowe jak i znaleziona konkurencja nie mają dużego związku z monitorowaną witryną.

Raven pozwala na monitorowanie fanpage’y na Facebooku, analizę projektu strony pod kątem {link_wew 6166}SEO{/link_wew} czy zbadanie jak wypada konkurencja w wynikach wyszukiwania. Możemy ponadto monitorować blogi, serwisy społecznościowe i portale pod kątem wybranych słów. Wszystkie te informacje możemy dołączyć do raportu i przedstawić klientowi nad którego stroną pracujemy. Darmowa wersja sprawdzi się idealnie przy analizie wprowadzonych zmian – miesiąc to odpowiedni czas do sprawdzenia reakcji internautów.

4. Web Site Optimization

http://analyze.websiteoptimization.com/

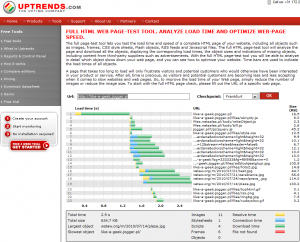

Jedna trzecia użytkowników opuszcza stronę, jeśli ta nie załaduje się ciągu 5-8 sekund. Na jakąkolwiek reakcję serwera (wczytanie tła, tekstu lub tytułu) przeciętnie oczekuje się przez 50 milisekund (0,05 sekundy). Jeśli po tym czasie nie będzie żadnej reakcji, użytkownicy są o krok od negatywnej oceny strony. Z tego powodu powinniśmy zadbać o to, aby witryna była dostępna jak najszybciej.

Szybkość ładowania witryny zależy od wielu elementów, m.in. od lokalizacji i szybkości serwera oraz rozmiaru plików. Witrynę warto przeanalizować pod kątem szybkości działania i zoptymalizować najwolniej ładujące się elementy. Można je zidentyfikować za pomocą narzędzia Web Site Optimization.

Pokaże ono czas ładowania każdego pliku, również pochodzącego z ramek i zewnętrznych serwerów i poda co zrobiliśmy dobrze, a które elementy należy poprawić. Przydatne będzie ponadto narzędzie http://www.uptrends.com/aspx/free-html-site-page-load-check-tool.aspx, w którym będziemy mogli wybrać lokalizacje, z której łączy się typowy użytkownik strony, a dane zobaczymy na wykresie.

5. CleanCSS

W zmniejszeniu rozmiaru strony pomogą optymalizatory kodu HTML i CSS. Wprowadzone przez nie poprawki zmniejszą rozmiar pliku o kilkanaście lub kilkadziesiąt procent eliminując niepotrzebne spacje i puste linie, łącząc powtarzające się atrybuty czy stosując skrócony zapis kolorów.

Niestety po kompresji zmniejsza się czytelność pliku, więc najlepiej dokonać jej na kopii, którą po ukończeniu strony umieścimy w warunkach produkcyjnych. Oryginał posłuży do ewentualnych poprawek. Optymalizacja kodu to zwykle szczegół, bo najwięcej czasu i tak zajmują odwołania do zewnętrznych serwerów i pobieranie plików multimedialnych. Dobrze zoptymalizowany kod przyśpieszy jednak renderowanie pobranej strony.

6. WAVE

Oprócz “zwykłych” internautów powinniśmy zadbać również o tych, którym przeglądanie treści sprawia problem – osoby niedowidzące i niewidome czy obsługujące komputer za pomocą niestandardowych urządzeń. Ma to szczególne znaczenie w przypadku witryn instytucji publicznych. Wszelkie utrudnienia i udogodnienia, na które natrafić mogą niepełnosprawni, skutecznie wykrywa WAVE (Web Accessibility Evaluation Tool).

Wave pokaże {link_wew 4754}błędy dostępności{/link_wew}. Wyjaśni też dlaczego nie powinniśmy stosować niektórych elementów i co należy poprawić, aby witryna była bardziej dostępna.

7. Searchmetrics rapid

http://rapid.searchmetrics.com

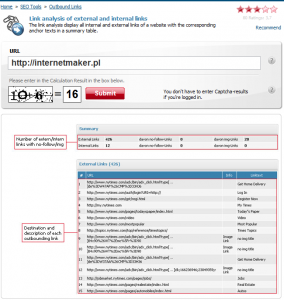

Na sukces strony w dużej mierze wpływa jej przyjazność dla wyszukiwarek internetowych i wszelkiego typu automatów indeksujących sieć. Oprócz linków pozycjonujących, powinniśmy zadbać o optymalizację samej witryny.

Należy zwrócić uwagę na liczbę linków na stronie (nie powinna przekraczać stu) i miejsc w które kierują, zagęszczenie słów kluczowych, na które będziemy pozycjonować czy odpowiedni dobór tagów. Przydatny okaże się ponadto podgląd wersji strony widzianej przez roboty wyszukiwarek.

Analizy możemy dokonać za pomocą narzędzi znajdujących się na stronie Searchmetrics rapid. Oprócz wymienionych danych, pobierzemy z niej również informacje o PageRanku stron, serwisach społecznościowych linkujących do naszej witryny i dowiemy się szczegółów na temat domeny pod którą działa strona. Po tym możemy porównać nasze wyniki z konkurencją.

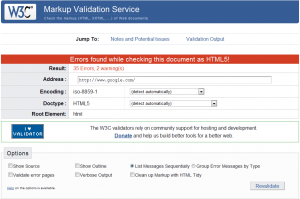

8. Walidator W3C

Kolejnym narzędziem, którego – mamy nadzieję – nie trzeba przedstawiać żadnej osobie pracującej z kodem HTML i CSS, jest walidator W3C. Walidatory wykonują automatyczne testy zgodności ze standardem, a co za tym idzie, z poprawnością wyświetlania witryny w rożnych przeglądarkach. W czasie pisania koder powinien od czasu do czasu sprawdzać, czy nie popełnił błędu, który może doprowadzić do „rozjechania się” strony.

Często zdarza się jednak, że webmasterzy dążą do uzyskania pozytywnego wyniku z walidatora (uwaga! niekoniecznie oznacza to stuprocentową zgodność ze standardem!), podczas gdy wcale nie jest to niezbędne. Jeśli dobrze wiemy dlaczego popełniamy “błąd” i jak wpłynie na zachowanie strony, to możemy zignorować komunikaty i ostrzeżenia walidatora. Przykład? Strona główna Google, która zwraca 35 błędów i 2 ostrzeżenia. Czy ktoś naprawdę myśli, ze ludzie z Google nie potrafią napisać poprawnej strony w HTML-u?

Przykład błędów zwracanych przez walidator w przypadku strony głównej Google pokazuje, że same testy to nie wszystko. Konieczna jest jeszcze interpretacja wyniku i wyciągnięcie wniosków. Wyniki działania wszystkich skryptów maja nam tylko pomóc zebrać dane, które – przynajmniej na razie – potrafi zinterpretować tylko człowiek. I dobrze, bo oznacza to, że jeszcze długo żaden skrypt nie zastąpi webmastera…