Algorytm Google bierze pod uwagę kilkaset czynników przy ustalaniu wyników wyszukiwania. Przyjrzyjmy się kilku szczegółom, które mają wpływ na pozycjonowanie.

Uwaga! Algorytm działania Google jest niejawny i ulega ciągłym zmianom (nawet kilka razy dziennie!), więc przedstawione w artykule informacje są jedynie przypuszczeniami. Staraliśmy się wybrać takie, które które w momencie pisania artykułu były potwierdzone przez praktyczne testy.

Google oparło swoją taktykę na ocenie linków prowadzących do strony, a nie samej treści. W związku z tym największy wpływ na pozycję w wyszukiwarce mają właśnie odnośniki. Poza tekstem odnośnika ważne jest miejsce z którego on pochodzi.

Głos społeczności

Najskuteczniejsze są te pochodzące z tzw. linkbaitingu, czyli tworzenia stron na tematy, które zdobędą dużo naturalnych linków oraz z blogosfery. Zasada jest prosta: skoro o czymś jest głośno w sieci, to kolejni wyszukujący powinni zostać skierowani do źródła, na które powołują się komentatorzy.

Można założyć, że Google będzie rozwijało swój algorytm właśnie w tym kierunku, wprowadzając kolejne funkcje związane z {link_wew 5603}wyszukiwaniem w czasie rzeczywistym{/link_wew}. W przyszłości na pozycjonowanie może więc mieć wpływ nie tyle wiarygodność strony, co samego autora linku! Obecnie Twitter pracuje nad algorytmem oceny najważniejszych obecnie informacji. Google prawdopodobnie robi to samo.

W połowie stawki źródeł, o których linki warto zabiegać, znalazły się zaufane katalogi (DMOZ, Onet, Yahoo) i serwisy społecznościowe gromadzące odnośniki (Digg, Reddit, Delicious). Najmniejszy wpływ na pozycjonowanie mają podpisy w stopkach na forach, bannery reklamowe i linki pochodzące z wszelkich automatycznie generowanych treści.

Jakość czy ilość?

Mimo wszystko nawet one niosą pewną wartość i odnośnik na wysoko cenionej stronie można zastąpić pewną liczbą tych pochodzących ze spamowych komentarzy, autoblogów itp. Jak wiele ich potrzeba? Testy pokazują, że jeden wartościowy link to równowartość tysięcy odnośników gorszej jakości.

Przy sprzedaży odnośników, systemach wymiany linków itp. dla ułatwienia bierze się pod uwagę Page Rank. Nie ma on bezpośredniego wpływu na pozycję strony w wynikach wyszukiwania, ale przy rozliczeniach spełnia swoją funkcję.

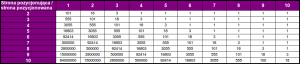

Tabela poniżej przedstawia szacunkową liczbę odnośników ze stron o danym PR (w kolumnach) potrzebną, by pozycjonowana strona osiągnęła wymagany Page Rank (wiersze). Przykładowo, jeśli mamy do dyspozycji 3 strony z PR5 to strona pozycjonowana zdobędzie PR4. Do osiągnięcia tego samego efektu potrzeba około 3000 stron pozycjonujących z PR1. Z tabeli wynika również, że odnośnik ze strony o PR7 automatycznie daje pozycjonowanej witrynie PR 6. Oczywiście są to wartości przybliżone i nieoficjalne, ale doświadczenie pokazuje, że często sprawdzają się w praktyce.

Skoro Google potrafi (lub niedługo będzie potrafiło) rozpoznać, czy odnośnik znalazł się w stopce w podpisie, czy to komentarz zaufanego bloggera, a liczba linków na kiepskich stronach potrzebna do pozycjonowania jest olbrzymia, to wydaje się, że zdobycie kilku mocnych linków jest łatwiejszym sposobem pozycjonowania niż opieranie się na spamie.

Mały szpieg od Google

Niestety nie jest to proste i zwykle sprowadza się do kupowania miejsca na wartościowych stronach. Nie jest to dobrze widziane przez Google, gdyż burzy ich model oparty na zaufaniu do linkujących. Podejrzane są niemerytoryczne hiperłącza kierujące do stron niezwiązanych tematycznie z witryną, zwłaszcza jeśli dodano ich kilka w krótkim czasie.

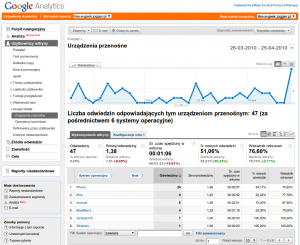

Google, dzięki wykorzystaniu statystyk {link_wew 3730}Analytics{/link_wew}, masowo instalowanych nawet w dużych serwisach, potrafi również ocenić zachowanie internautów na danej stronie. Wie, które treści wciągnęły ich najbardziej (pośrednio, przez badanie czasu odwiedzin w stosunku do długości tekstu) i w jakie odnośniki klikali najczęściej. Pod uwagę brane są również takie szczegóły jak stosunek liczby osób, które dodały i usunęły stronę z ulubionych czy ruch generowany przez witrynę. Ważne jest również, aby popularność i ruch na stronie stale rosły, co jest naturalnym zjawiskiem. Jak widać, statystyki wcale nie służą tylko webmasterom, ale również firmie w ustalaniu wyników wyszukiwania.

Istnieją nawet podejrzenia, że rozpoznawany jest charakter ruchu. Typowy użytkownik zachowuje się inaczej niż ten, któremu zapłacono na wejście na stronę. Kupowanie ruchu dla samych statystyk może negatywnie wpłynąć na pozycjonowanie, ale jest to jeden z marginalnych czynników.

Stary serwis, nowa treść

Poza tym lepiej punktowane są duże serwisy zawierające wiele podstron ułożonych w strukturę drzewa. W indeksowaniu nowych stron pomaga mapa witryny i wysyłanie informacji o nowych dokumentach (pingowanie). Ważny jest również wygląd strony (czy witryna nie jest gotowcem postawionym na domyślnym szablonie CMS-a) i jej wiek. Zazwyczaj wysoko cenione są stare strony, chociaż również bardzo nowe (1-3 tygodnie) mogą liczyć na premię w wynikach wyszukiwania. Najlepiej ocenia się świeże podstrony starych serwisów. Wiąże się to właśnie z promowaniem bieżących tematów. Same linki powinny być na stronie jak najdłużej – ich częsta zmiana może świadczyć o stosowaniu systemu rotacyjnego.

Co z treścią?

Oprócz linków istotne są używane słowa kluczowe, których poszukują internauci. Duży wpływ na wyniki wyszukiwania ma użycie ich w tytule strony, najlepiej na początku i w nazwie domeny. To samo dotyczy tytułów i śródtytułów tekstu.

Mniejsze znaczenie mają słowa kluczowe w dalszej części adresu (np. domena.pl/slowo-kluczowe.html) i początkowych 50-100 słowach tekstu. Z tego powodu warto umieścić tagi na początku artykułu.

Najmniej istotne są wyrazy znajdujące się w zmiennych w adresie ({stala}domena.pl/podstrona.php?slowo=kluczowe{/stala}) oraz podane jako słowa kluczowe w metatagach.

Umieszczenie na pozycjonowanej stronie reklam (w szczególności AdSense), widgetów serwisów społecznościowych i obiektów Flasha lub Silverlighta w minimalnym stopniu wpływa na jej ocenę.

Podobne badania przeprowadzane są na stronach linkujących do pozycjonowanej. Mówi się czasem, że nie można zostać ukaranym za to, kto linkuje do naszej strony, ale nie jest to do końca prawda. Google wykrywa regularne i nienaturalne struktury, takie jak kręgi wzajemnie promujących się witryn i zmniejsza ich znaczenie przy ogólnej wycenie jakości. Pozostałe czynniki pozostają niezmienne. Przynajmniej do tego stopnia, w którym „niezmiennym” można nazwać algorytm zawierający kilkaset czynników poprawianych każdego dnia…