Narzędzia Google dla webmasterów umożliwiają szybkie i łatwe dostosowanie strony do współpracy z wyszukiwarką. Właściciel strony może sprawdzać, jak widzi ją Google, dowiedzieć się o problemach i podać wiele informacji robotowi wyszukiwarki.

Narzędzia oferowane przez Google

(http://www.google.com/webmasters/sitemaps) to statystyki, diagnostyka i mapy

witryn. Zapewniają wszechstronne

i efektywne indeksowanie oraz przyspieszają

wykrywanie nowych stron.

Praca rozpoczyna się od dodania adresu

strony. Następnie należy potwierdzić,

że jest się właścicielem strony

z prawem do administrowania witryną.

Pierwszy sposób potwierdzenia to wysłanie

na serwer pliku z nazwą generowaną

przez system, drugi to umieszczenie

znacznika META również z generowaną

wartością.

Po prawidłowej weryfikacji narzędzia

dostarczają szczegółowych statystyk oraz

informacji o każdej stronie. Przy braku weryfikacji

narzędzia dają ograniczone możliwości,

zawężone do przesyłania map witryn,

wyświetlania podstawowych informacji

o mapach i samej stronie.

Diagnostyka

Pierwszy wyświetlany ekran to diagnostyka.

W sekcji Podsumowanie widać

datę ostatniej wizyty robota Google

na stronie głównej. Na drugim miejscu

jest stan zaindeksowania stron, który

pokazuje czy znajdują się one w indeksie

wyszukiwarki. Może wystąpić sytuacja,

że w indeksie nie ma jeszcze stron

z nowej domeny. Wtedy narzędzie poinformuje: \”W indeksie Google nie są aktualnie

uwzględnione żadne strony tej witryny. Zaindeksowanie

może zająć trochę czasu\”.

W sekcji Błędy indeksowania jest przedstawiona

lista adresów internetowych, z których

zaindeksowaniem robot miał trudności. Wykrył

te strony albo w adresach pochodzących z mapy

witryny, albo korzystając z odnośników na innych

stronach podczas przemierzania internetu.

Podany jest rodzaj oraz ile razy ten błąd wystąpił.

Najczęstszym błędem jest nie znalezienie

dynamicznie generowanych stron.

Narzędzia diagnostyczne

Główne narzędzia diagnostyczne dzielą się na

sekcje: Analiza pliku robots.txt, Szybkość indeksowania,

Preferowana domena. W sekcji Analiza

pliku robots.txt jego zawartość jest sprawdzana

pod kątem wywoływanych efektów przy indeksowaniu.

Plik robots.txt sugeruje robotowi

wyszukiwarki, aby nie przeglądał lub nie pobierał

części albo całości indeksowanej strony.

W pliku znajdują się komendy sterujące robotem.

Ogranicza się w nim dostęp do niektórych

katalogów lub dla konkretnych robotów.

Polecenie User-agent:*, Disallow:/ informuje

wszystkie roboty wyszukiwarek, że nie

wolno im przeglądać całej witryny. Dla robota

Google w linii user-agent należy podać

wartość Googlebot. W poleceniu Disallow

można wstawić nazwę katalogu, który będzie

wyłączony z indeksowania (np. /news), typ pliku

(np. /*.gif$) bądź wszystkie dynamicznie

generowane strony (np. /*?).

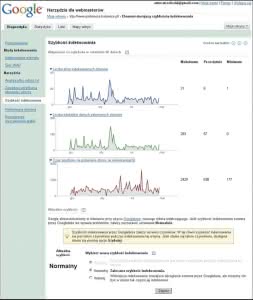

Sekcja Szybkość indeksowania ilustruje prędkość

poruszania się robota po witrynie. Wyświetlane

są trzy wykresy przedstawiające informacje

na temat liczby stron indeksowanych dziennie,

pobieranych dziennie kilobajtów danych oraz

czas spędzony na pobieraniu strony. Informacje

o szybkości indeksowania strony przez Googlebota

pochodzą z ostatnich 90 dni.

Sekcja Preferowana domena określa czy wyszukiwarka

ma pokazać, czy ukryć w wynikach

wyszukiwania przedrostek WWW w adresie

strony.

Statystyka

W zakładce Statystyka znajdują się sekcje informujące

o wynikach w rezultatach wyszukiwania

pozycji w rankingu PageRank, liście

słów kluczowych znajdujących się na stronie

oraz w odnośnikach prowadzących do witryny.

Statystyka może być chwilowo niedostępna.

Wynika to z różnych przyczyn, na przykład

robot do tej pory nie zebrał wystarczających

danych statystycznych o stronie.

Sekcja Statystyki indeksowania (ang. crawl

stats) zawiera informacje dotyczące zaindeksowanych

stron witryny. Dostępne są dane

o pozycji stron w rankingu PageRank w porównaniu

do wszystkich stron znajdujących

się w bazie Google, a także adres pojedynczej

strony z najlepszą pozycją w rankingu

PageRank.

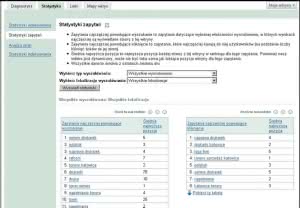

Sekcja Statystyki zapytań (ang. query stats)

zawiera informacje na temat słów kluczowych,

które Google podaje w wynikach.

Zapytania powodujące wyszukanie to lista

słów kluczowych dla których witryna była

najczęściej wyświetlana w wyszukiwarce, natomiast

zapytania powodujące kliknięcie to

lista słów kluczowych, dla których witryna

była najczęściej klikana jako odnośnik w wyszukiwarce.

Te zapytania kierowały użytkowników

do witryny.

Sekcja Analiza stron (ang. page analysis) podaje

informacje o typach treści znajdujących

się na stronach witryny, np. statyczne strony

HTML, strony dynamiczne, animacje flash

itp. Odczytywane jest też kodowanie znaków

w treści i najważniejszy element, typowe słowa

zawarte w treści i w odnośnikach do witryny,

które najlepiej (zdaniem wyszukiwarki)

ją charakteryzują.

Ostatnia sekcja, o identycznym tłumaczeniu

jak nazwa pierwszej, Statystyki indeksowania

(ang. index stats), jest oparta na wynikach

wyszukiwania przy użyciu szukania zaawansowanego.

Szukanie zaawansowane jest

rzadko stosowane, jednak podaje wiele cennych

informacji. Operator site wyświetla listę

wszystkich stron znajdujących się w indeksie.

Lista przykładowych stron zawierających odwołanie

do adresu internetowego witryny jest

wyświetlana za pomocą polecenia allinurl.

Listę z odnośnikami do witryny ujawni polecenie

link. Klikając polecenie cache ujrzymy

aktualną kopię witryny w pamięci podręcznej,

klikając polecenie info uzyskamy opis strony,

a polecenie related pokaże listę stron

podobnych.

Wszystkie dane statystyczne są dostępne

do pobrania w formacie CSV, więc można je

otworzyć np. w Excelu.

W zakładce Linki wyświetlane są wszystkie

odnośniki do witryny – zarówno zewnętrzne,

jak i wewnętrzne. Aktualizacja tych odnośników

odbywa się raz w miesiącu.

Mapa witryny

Narzędzie Mapy witryn ułatwia robotom wyszukiwarek

efektywne przeglądanie witryn

oraz indeksowanie ich treści. Zyskują także

użytkownicy wyszukiwarek: dzięki niemu

mogą bezpośrednio z wyszukiwarki trafić na

właściwą podstronę. Google, Yahoo! i Live Search

będą wspólnie pracować nad protokołem

Sitemaps i publikować wprowadzone do niego

usprawnienia na stronie http://www.sitemaps.org. Webmasterzy zyskują uniwersalne

narzędzie, które pozwoli im dostarczać informacje

o witrynie.

Na stronie https://siteexplorer.search.yahoo.com/mysites po wcześniejszym zarejestrowaniu

można dodawać mapy witryn do

wyszukiwarki Yahoo!. Procedura jest analogiczna

do stosowanej w narzędziu Google.

Protokół Sitemaps umożliwia informowanie

wyszukiwarek o adresach internetowych

dostępnych do zindeksowania. Mapa witryny,

która korzysta z protokołu Sitemaps, to plik XML zawierający listę adresów internetowych.

Protokół umożliwia obsługę witryn

o dowolnym rozmiarze, z jedynym ograniczeniem,

że rozmiar nieskompresowanego pliku mapy witryny nie może przekraczać 10 MB.

Ponadto przekazuje dodatkowe informacje o dacie

ostatniej aktualizacji, częstotliwości zmian

i priorytetach adresów internetowych. Rozwiązanie

jest szczególnie użyteczne w przypadku

dynamicznych stron, których zawartość zmienia

się bardzo często. Dla wielu wydawców

najważniejsze jest, że większa ilość treści będzie

indeksowana w krótszym czasie.

Mapa witryny jest przydatna, gdy użytkownicy

nie mogą dotrzeć do wszystkich obszarów

strony. Protokół Sitemaps uzupełnia mechanizmy

oparte na indeksowaniu, już stosowane

przez wyszukiwarki do wyszukiwania adresów

internetowych, ale ich nie zastępuje. Zgłaszając

mapę witryny do wyszukiwarki ułatwia się

indeksowanie strony przez roboty wyszukiwarek.

Jednak nie gwarantuje to uwzględnienia

witryny internetowej w indeksie wyszukiwania

oraz nie ma wpływu na wyznaczanie pozycji

w wyszukiwarce.

Można przesłać wiele plików map witryn,

ale każdy z nich nie może zawierać więcej

niż 50 tys. adresów internetowych w obrębie

danej strony i mieć rozmiar nie większy

niż 10 MB (10485760 bajtów). Te limity

zapewniają, że serwer internetowy nie zostanie

przeciążony obsługując bardzo duże

pliki. Zaleca się umieszczenie mapy witryny

w katalogu źródłowym serwera internetowego.

Gdy serwer internetowy znajduje się

w domenie przykład.pl, to plik mapy witryny

należy umieścić w lokalizacji http://www.przyklad.pl/sitemap.xml.

Jest kilka sposobów na stworzenie mapy

witryny. Najprostszy, który daje najmniej kontroli

nad tworzeniem map, to generatory XML

online (np. http://www.xml-sitemaps.com),

które automatycznie przejrzą strony i wygenerują

dla nich plik XML. Webmasterowi pozostanie

tylko załadowanie pliku na serwer

internetowy i poinformowanie wyszukiwarki

o jego obecności. Podstawowa wada generatora

online to konieczność stworzenia pliku

od nowa po każdej zmianie lub dodaniu

strony do witryny.

Większą kontrolę nad parametrami

pliku mapy witryny zapewni odpowiedni

skrypt, skonfigurowany i uruchomiony

na serwerze. Może on być napisany w dowolnym

języku skryptowym, takim jak PHP albo

Perl. Skrypt powinien generować automatycznie

plik mapy witryny w regularnych odstępach

czasu i zapisywać go na serwerze w odpowiednim

miejscu. Google na swoich stronach

pomocy udostępnia skrypt o nazwie Sitemaps

Generator wraz z instrukcją krok po

kroku. Nowsze systemy CMS, jak Joomla, mają

komponenty, które automatycznie i regularnie

generują mapę witryny.

Po utworzeniu mapy witryny trzeba powiadomić

wyszukiwarki o jej lokalizacji. Pobrana

wówczas mapa witryny udostępni adresy internetowe

robotom indeksującym.