Dziś trudno sobie wyobrazić, że mógł istnieć świat bez sieci. A przecież jeszcze kilkanaście lat temu, gdy rodziła się większość obecnych internautów, Polska była białą plamą na internetowej mapie świata.

Brzmi to trochę jak paradoks, ale to właśnie Rosjanom, zimnej wojnie, strachowi przed bombą wodorową zawdzięczamy dzisiejszy symbol wolności i zjednoczenia świata.

W latach 50. ubiegłego stulecia wiadomo było, że dwa najpotężniejsze państwa na świecie mają olbrzymie arsenały broni atomowej. Jedynym problemem związanym z jej wykorzystaniem były kłopoty z przeniesieniem tejże broni na terytorium przeciwnika, aby efektywnie jej użyć. Owszem, istniały samoloty dalekiego zasięgu, ale one zawsze mogły być dość wcześnie wykryte przez radary i przechwycone na tyle szybko, że nie zdążyłyby wspomnianej bomby użyć.

4 października 1957 roku, a wiec 50 lat temu, Związek Radziecki z wielką dumą poinformował, ze umieścił na orbicie okołoziemskiej pierwszego sztucznego satelitę Ziemi, noszącego nazwę Sputnik (ros. towarzysz podroży, satelita). Amerykanie, którzy wierzyli, że to im przypadnie w udziale pierwszy krok w kosmos, byli zszokowani. Od tego momentu wiedzieli, że Rosjanie mają nie tylko stosowne ładunki atomowe, ale też, że są w stanie wykorzystać rakiety kosmiczne do ich przeniesienia nad terytorium USA.

Prezydent Eisenhower nakazał przyspieszenie prac nad amerykańskim programem kosmicznym oraz szersze przyjrzenie się rozwojowi nowych technologii, które mogłyby mieć potencjalnie znaczenie militarne.

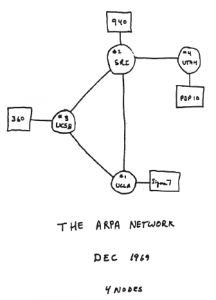

I tak, w styczniu 1958 roku doszło do powstania ARPA (Advanced Research Projects Agency – Agencja Zaawansowanych Projektów Badawczych, później przekształcona w DARPA – Defense Advanced Research Projects Agency). Jednostka ta miała za zadanie rozdział sporych pieniędzy pomiędzy zespoły badawcze skupione na krótkoterminowych programach mających mniej lub bardziej bezpośredni związek z obronnością USA.

W pierwszych latach istnienia główny nacisk położony był oczywiście na program kosmiczny, czego pośrednim efektem było powstanie NASA. W drugiej połowie lat 60. ARPA rozszerzyła swoją działalność m.in. na prace związane z zastosowaniem komputerów w obronności. I tak właśnie docieramy do źródeł internetu.

Prapoczątki – zarzucamy sieć…

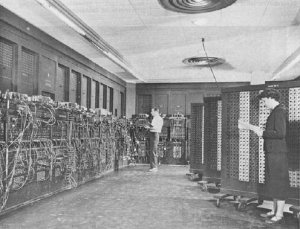

W latach 50. i 60. ubiegłego wieku komputer był urządzeniem prawie nieznanym, dostępnym tylko dla nielicznego grona wielkich wtajemniczonych. W owych czasach mało kto myślał o tym, aby w jakiś sposób łączyć komputery ze sobą, ponieważ nikt nie widział po prostu takiej potrzeby.

Musimy pamiętać, że w owych czasach firma IBM prognozowała zapotrzebowanie (światowe!) na komputery na liczbę 10 sztuk rocznie. Oczywiście komputery też wyglądały wtedy zupełnie inaczej niż nasze poczciwe pecety i laptopy.

Człowiek jest jednak istotą stadną, a ponadto coraz częściej praca nad pewnymi większymi projektami z zakresu informatyki wymagała współdziałania mniejszej lub większej grupy ludzi. Jeśli byli oni pracownikami jednej instytucji lub też znajdowali się fizycznie w jednym mieście, sprawa była dość prosta. Wystarczyło się spotkać w umówionym czasie i miejscu, aby rozwiązać bieżące problemy i podzielić się nowymi zadaniami. Z czasem jednak przestało to wystarczać. Projekty rozrastały się, a czasu jak zawsze było za mało. Pod koniec lat 60. oczywistym stał się fakt, że niezbędne jest połączenie sił (czytaj: komputerów).

Sprawa była w miarę prosta, gdy mieliśmy do czynienia z komputerami tego samego producenta, działającymi zgodnie z tymi samymi programami. Jednakże we wczesnej epoce informatycznej w zasadzie każdy producent wypuszczał maszynę pracującą według zupełnie innego programu (wtedy nawet nie nosił on miana systemu operacyjnego). Połączenie takich maszyn, nawet znajdujących się bardzo blisko siebie, było zadaniem niezwykle trudnym.

W jakimś sensie można by to porównać do tłumu ludzi zamkniętych w jednym pomieszczeniu i usiłujących wspólnie pracować nad jakimś zagadnieniem. Jeśli mówią oni tym samym językiem, sprawa jest prosta. Cała rzecz komplikuje się jednak, gdy wyobrazimy sobie grupę ludzi, z których każdy używa zupełnie innego języka. Możliwość współpracy w takim tłumie w zasadzie spada do zera, mimo że każdy może być doskonałym specjalistą w danej dziedzinie.

Oczywiście nie ma sytuacji bez wyjścia – najprostszym sposobem jest wprowadzenie w ten tłum czegoś w rodzaju indywidualnych tłumaczy. Doskonałą ilustracją (w dziedzinie powieści SF) jest słynna \”rybka Babel\” występująca w cyklu powieściowym Douglasa Adamsa \”Przewodnik autostopowicza po galaktyce\”.

W przypadku komputerów rolę swoistego tłumacza miedzymaszynowego spełniają protokoły komunikacyjne, które biorą na siebie ciężar nawiązywania komunikacji oraz wymiany danych pomiędzy połączonymi ze sobą komputerami. Należy tu podkreślić, że sama idea protokołu komunikacyjnego jest zdecydowanie starsza niż sieci komputerowe – już wcześniej była realizowana przy pracy tzw. teleksu (nie mylić z telefaksem).

Protokołem komunikacyjnym, uznanym powszechnie za standard w internecie, stał się TCP/IP (Transmission Control Protocol/Internet Protocol).

TCP/IP – jądro internetu

Aby zrozumieć sposób, w jaki działa internet, należy choćby w skrócie zapoznać się z zasadniczą ideą transmisji informacji w sieci. Nie zamierzam wdawać się w szczegóły techniczne, myślę jednak, że dla samej ciekawości warto choćby z grubsza rozumieć, co dzieje się, gdy na przykład wysyłamy e-mail lub oglądamy stronę WWW.

Jak wiadomo, informacje w sieci zakodowane są jako ciąg znaków (liczb). Jak takie ciągi są przesyłane od komputera do komputera? Wyobraźmy sobie, że mamy firmę kurierską, której kurierzy transportują tylko przesyłki o wadze do 1 kg. Zamierzamy wysłać komuś w drugim końcu miasta nasze wspomnienia zapisane na wielu kartkach – całość niestety waży 12 kg.

Oczywiście firma przyjmie przesyłkę w całości, ale musi ją sprytnie podzielić na paczki ważące nie więcej niż 1 kg. Następnie dyspozytor ustala najszybszą trasę przesyłki, ponieważ przecież cały czas sytuacja na ulicach jest dynamiczna, tworzą się korki, które spowalniają ruch. Następnie kurierzy dostają kolejne paczki, odpowiednio ponumerowane.

Odbiorca oczekuje na przesyłki, które oczywiście mogą do niego dotrzeć w dowolnej kolejności. Po otrzymaniu każdej przesyłki kontaktuje się z firmą, potwierdzając otrzymanie paczki. Tenże odbiorca sprawdza przy okazji czy zawartość paczki jest zgodna z deklaracją – jeśli tak nie jest, prosi o jej ponowne przysłanie (zakładamy, że firma może wykonać drugą kopię każdej paczki). Gdy już wszystkie przesyłki dotrą na miejsce, odbiorca potwierdza ich otrzymanie, kończąc w ten sposób całą transakcję.

Mniej więcej w taki sam sposób działa internetowy protokół TCP/IP. Jest on odpowiedzialny za kilka podstawowych czynności: sprawdzenie tożsamości odbiorcy, zarządzanie przekazywaniem pakietów, sterowanie przepływem (omijanie korków) oraz wykrywanie i obsługę błędów. Wielką zaletą protokołu TCP/IP jest to, że działa on między różnymi platformami, a więc pozwala łączyć między sobą różne komputery używające różnych systemów operacyjnych.

\”Paczką\” w rozumieniu transmisji sieciowej jest tzw. pakiet, zwany inaczej datagramem. Każdy pakiet składa się z nagłówka oraz obszaru danych. Nagłówek zawiera dane odbiorcy, a także określa zawartość danego pakietu.

Informacja przesyłana od nadawcy do odbiorcy zwykle składa się z szeregu pakietów, przy czym każdy z nich może być wysyłany inną trasą, zależną od aktualnego ruchu w sieci. I właśnie protokół TCP/IP zarządza wysyłaniem i odbiorem wszystkich pakietów, na bieżąco sprawdzając czy wszystko dotarło do adresata i czy zawartość pakietów nie została po drodze zmieniona.

Modemy dawniej i dziś

Połączenie pomiędzy odległymi komputerami prawie od samego początku było realizowane za pośrednictwem sieci telefonicznej. Jednak sieć ta z założenia przystosowana była do transmisji sygnału analogowego, podczas gdy komputery posługują się danymi cyfrowymi. Stąd właśnie powstała konieczność zastosowania odpowiednich urządzeń – modemów.

Słowo \”modem\” jest skrótem dwóch słów – modulacja/demodulacja. Urządzenie to służy do przekształcania sygnału cyfrowego na analogowy (to właśnie modulacja) i odwrotnie (demodulacja). Oba te procesy są niezbędne, aby dane cyfrowe mogły być transmitowane za pomocą kabla, który służy do transmisji analogowej (jak np. linia telefoniczna lub energetyczna).

Historia modemów jest ściśle związana z wojskowością, albowiem pierwsze modemy zostały zaprojektowane w końcu lat 50. ubiegłego wieku na potrzeby systemu obrony powietrznej USA. Pierwszy komercyjny modem Bell 103 został wyprodukowany przez firmę AT&T i przesyłał dane z prędkością 300 b/s (oznacza to, że wczytywanie średniej dzisiejszej strony WWW trwałoby co najmniej 10 minut, a transmisja przeciętnej piosenki nagranej w MP3 ok. 10 godzin). W ciągu krótkiego czasu prędkość transferu została zwiększona do 1200 b/s, ale niestety stan ówczesnych linii telefonicznych nie pozwalał na nic więcej.

W początkach lat 80. przepustowość modemów została zwiększona do 14,4 kb/s (na dzierżawionych liniach czterożyłowych), natomiast zwykłe linie telefoniczne pozwalały na transmisję z maksymalną prędkością 9,6 kb/s. Kolejny skok technologiczny został dokonany dopiero na początku lat 90., gdy modemy pracujące na zwykłych liniach telefonicznych osiągnęły przepustowość 14,4 kb/s, a trochę później, w 1994 r., 28,8 kb/s. Dzisiaj najszybsze modemy działające w oparciu o wysłużoną technologię modulacji/demodulacji, osiągają 56 kb/s.

Era tradycyjnych modemów już się kończy. Ze względu na coraz większe wymagania odnośnie przepustowości łączy opracowano zupełnie nowe technologie, takie jak xDSL, WiFi czy WiMAX, które zapewniają prawdziwie gigantyczne – w porównaniu do pierwotnych 300 b/s – prędkości transferu liczone w megabitach na sekundę. Zaś na duże odległości dane przesyła się w postaci cyfrowej światłowodami bądź drogą satelitarną.

Łączenie z internetem wczoraj i dziś

Gdy w Polsce zaczęto się interesować internetem, o łączeniu się z domu można było tylko pomarzyć. Klasycznym miejscem, w którym wtedy odbywały się spotkania z siecią, były pracownie komputerowe na uczelniach. Nieco później, gdy tu i ówdzie oferowany był dostęp do internetu, maniacy komputerowi zostali zmuszeni do mozolnej konfiguracji swoich pecetów. Wówczas wtajemniczeni znali na pewno dwa kluczowe słowa – winsock oraz Trumpet.

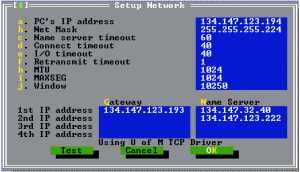

Aby uświadomić młodszym Czytelnikom, jak to wszystko wyglądało, podam skrótowo sposób w jaki na początku lat 90. ubiegłego wieku przebiegało konfigurowanie komputera do połączenia z siecią.

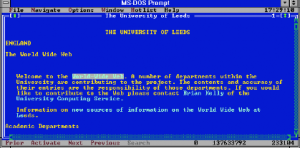

Internet pod kontrolą DOS-u

Przyznam, że dla początkujących była to niezła szkoła. Pół biedy, jeśli miało się peceta połączonego stałym łączem z siecią, ale w owych czasach było to raczej marzenie. Przytłaczająca większość dysponowała tylko modemem i tzw. połączeniem wdzwanianym (dial-up).

Aby skonfigurować takie połączenie, należało najpierw postarać się o sterownik sieciowy, czyli program pozwalający na obsługę protokołu TCP/IP, a następnie o stosowne aplikacje, które przy zastosowaniu tego sterownika pozwalały korzystać z zasobów i usług sieci, takich jak poczta, WWW (wtedy jeszcze w powijakach), IRC. Oczywiście wszystkie te programy należało zdobyć i wgrać do komputera przenosząc je na dyskietce.

Sterownik sieciowy był zwykle uruchamiany razem ze startem systemu (należało umieścić odpowiednią komendę w pliku AUTOEXEC.BAT, który był plikiem startowym systemu; były to jeszcze czasy DOS-a i Windows 3.1), natomiast sam proces wdzwaniania, czyli łączenia się z dostawcą internetu, realizowany był przez program zwany dialerem.

Zazwyczaj dialer musiał być dodatkowo konfigurowany w zależności od posiadanego modemu oraz innych parametrów. Wartości te trzeba było wpisać ręcznie, modyfikując odpowiednie konfiguracyjne pliki startowe. Internauta uczył się wtedy takich komend jak np. inicjacja modemu (komenda ATZ), musiał wiedzieć czy jego telefon ma wybieranie impulsowe czy tonowe itd.

Ważna była tez znajomość tzw. numeru przerwania (słynny 0x60), aby w odpowiednim miejscu skryptu wpisać stosowną komendę kończącą połączenie.

Dopiero po przebrnięciu przez wszystkie meandry konfiguracji można było zabrać się za instalację (i oczywiście konfigurację) odpowiednich aplikacji. I znów poznawało się tak egzotyczne nowe nazwy, jak np. Minuet. Ech, wspomnienia…

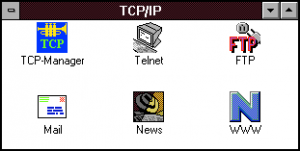

Internet w starym Windows, czyli bez trąbki ani rusz!

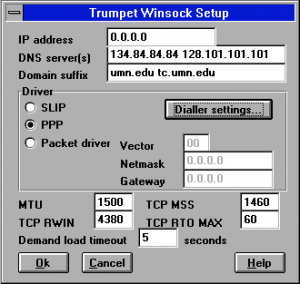

Oczywiście nie chodzi tutaj o instrument Milesa Davisa, ale o słynny Trumpet (a dokładniej – Trumpet Winsock), który był w zasadzie najważniejszym programem pozwalającym połączyć się z siecią w czasach Windows 3.1. W tym przypadku konfiguracja systemu była zdecydowanie łatwiejsza, oczywiście w porównaniu z opisanym DOS-em.

Polegała ona w zasadzie na wpisaniu danych dotyczących adresu IP (wtedy nie marzono jeszcze o DHCP), adresu serwera nazw domenowych (DNS), podaniu protokołu, za pomocą którego będziemy się łączyć, a następnie stosownej konfiguracji modemu.

Pierwotnie samo dzwonienie odbywało się właściwie ręcznie (słynna komenda modemowa \’adtp\’), a więc należało pamiętać o tym, aby się potem rozłączyć – a i tak rachunki były kosmiczne.

Typową instrukcję instalacji Trumpet Winsock można obejrzeć pod adresem http://learning.lib.vt.edu/wintcpip/trumpwsk.html.

Całe szczęście nadeszła era Windows 95, w którym z założenia był instalowany pakiet programów łączących z internetem, a więc przeciętny \”zjadacz bitów\” nie musiał się już tym martwić. W chwili obecnej prawie każdy system operacyjny jest konstruowany z założeniem, że komputer będzie podłączony do internetu. Powoli wymierają też połączenia wdzwaniane, ponieważ stałe łącze zaczyna być nawet w Polsce standardem.

Co będzie dalej? Zobaczymy. Zapewne internet oplecie jeszcze szczelniej świat i połączenia \”kabelkowe\” w domu przestaną być konieczne, ponieważ wszędzie będzie szybki dostęp bezprzewodowy. To tylko kwestia czasu, i to wcale nieodległego.

Gdzie to jest? Krótka historia wyszukiwarek sieciowych

Szybki rozwój internetu spowodował konieczność systematyzowania informacji zawartych w sieci. Dlatego też tylko kwestią czasu było zaistnienie mechanizmów pozwalających na wygodne i proste przeszukiwanie zasobów sieciowych.

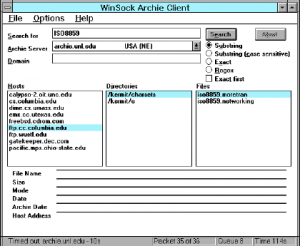

Archie

Za pradziadka wyszukiwarek internetowych należy uznać serwis Archie. Tak naprawdę nie był to jednak system podobny do dzisiejszego Google czy Yahoo. Archie był w zasadzie mechanizmem pomocniczym usługi FTP i pozwalał na przeszukiwanie zasobów umieszczonych na serwerach FTP.

Zapytanie skierowane do Archiego dawało w odpowiedzi listę plików, które później można było ściągać z konkretnych lokalizacji. Cały system był dość toporny, ale w owym czasie uznawaliśmy go za absolutną rewolucję. Pierwotna wersja Archiego powstała w 1990 roku. Wraz z powstaniem i rozwojem WWW Archie zaczął szybko tracić na znaczeniu.

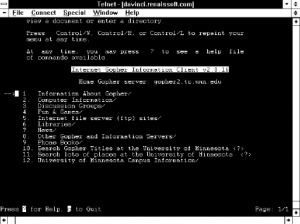

Gopher

Kolejnym, obecnie już historycznym systemem informacyjnym pozwalającym na wyszukiwanie danych w zasobach internetu był Gopher. Był on o krok dalej niż Archie, ponieważ pozwalał nie tylko na wyszukiwanie plików w serwisach FTP, ale także na znajdowanie plików graficznych i danych binarnych. Powstał w 1991 roku, ale jego popularność trwała bardzo krótko – głównie dlatego, że na scenie pojawiły się strony WWW, a wraz z nimi zupełnie inne rodzaje wyszukiwarek.

Sama nazwa \”gopher\” oznacza sympatycznego gryzonia noszącego polska nazwę… świstak! Zwierze to przypomina nieco kreta, drąży korytarze, poszukuje w ziemi rożnych ciekawych rzeczy… Myślę, że nazwa pasowała idealnie do tego, co serwis Gopher rzeczywiście robił.

Veronica

Nieco później niż Archie (w 1992 r.) powstała prababka wyszukiwarek – Veronica. Była bezpośrednio związana ze wspomnianym Gopherem – stąd zresztą jej nazwa, będąca akronimem angielskiego Very Easy Rodent-Oriented Net-wide Index to Computer Archives, czyli Bardzo Prosty Nakierowany na Gryzonie Sieciowy Indeks Archiwów Komputerowych.

Wszyscy, którzy pamiętają system Veronica, muszą się zgodzić z tym, że był bardzo prosty w obsłudze. Tak naprawdę serwisy Veronica dzięki grupce pasjonatów istnieją do dziś, nieco zmienione, ale nadal bardzo proste w obsłudze.

WWW – świt nowej ery internetu

Dziś dość trudno wyobrazić sobie internet bez WWW (World Wide Web, czyli Ogólnoświatowej Pajęczyny). Niektórzy nawet utożsamiają te dwa pojęcia, chociaż tak naprawdę WWW jest tylko jedną z wielu usług dostępnych w sieci.

Wszystko zaczęło się na przełomie lat 80. i 90. ubiegłego wieku. Tim Berners-Lee, brytyjski konsultant pracujący w Europejskim Ośrodku Badan Jądrowych (CERN) w Genewie, zaproponował bardzo wygodny sposób poruszania się w gąszczu danych oraz dokumentów.

Pierwotnie jego pomysł miał wspomóc wielotysięczną rzeszę pracowników CERN, którzy niejednokrotnie mieli kłopoty z dotarciem do odpowiednich danych wytworzonych w ośrodku, jednak szybko okazało się, że można ten system przeskalować w górę, tak aby sprawnie poruszać się w ogólnoświatowej sieci. Idea WWW oparta była na hipertekście, czyli systemie organizacji danych połączonych za pomocą tzw. hiperłączy.

Berners-Lee jest również autorem pierwszej przeglądarki internetowej (będącej jednocześnie prostym edytorem), nazywającej się po prostu WWW. Odznaczała się dużą prostotą oraz funkcjonalnością. Niestety, rozwój jej został zarzucony.

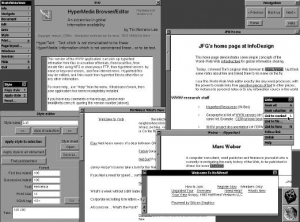

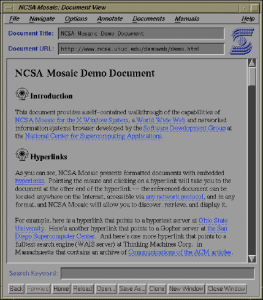

Gdy świat zaczął dostrzegać zalety idei WWW, dość szybko zaczęły pojawiać się programy umożliwiające przeglądanie tworzonych coraz częściej stron WWW. Pierwszą ogólnodostępną przeglądarką działającą w trybie graficznym, która szybko zdobyła uznanie internautów, była NCSA Mosaic, napisana na uniwersytecie w Illinois.

Niedługo po światowej premierze NCSA Mosaic inni programiści także zaczęli tworzyć przeglądarki. Pod koniec 1994 roku ukazała się wersja 0.9 istniejącej do dziś przeglądarki Netscape Navigator. Tak naprawdę przeglądarka nazywała się Navigator, ale wszyscy nazywali ja (od nazwy firmy) Netscape.

Na owe czasy przeglądarka ta była bardzo zaawansowana technologicznie. Działała bardzo sprawnie i była zdecydowanie szybsza niż Mosaic, dlatego też szybko stała się absolutnym liderem na rynku. Najnowsza wersja Netscape\’a nosi numer 8 i nadal jest znaczącą pozycją na rynku przeglądarek internetowych.

Oczywiście w tamtych czasach nie wszyscy internauci mieli systemy Windows czy Linux, wiele komputerów miało nadal monochromatyczne karty graficzne, i nie mogli posługiwać się przeglądarkami Mosaic czy Netscape. Dlatego też w powszechnym użyciu były przeglądarki tekstowe, z których jedną z popularniejszych był Lynx. Starsi internauci zapewne pamiętają strony oglądane pod Lynxem, gdzie w miejscu, w którym zwykle pojawia się obrazek, widniała lakoniczna informacja \”obraz graficzny\”.

Dziś świat przeglądarek jest w zasadzie opanowany przez Internet Explorera i Firefoxa, chociaż wielu użytkowników wybiera nadal Netscape\’a, Operę lub inne mniej znane programy tego typu. Jedno jest pewne – użytkowanie internetu bez przeglądarki stron WWW jest właściwie niemożliwe.

Internet a sprawa polska

Często spotykam się z pytaniem młodszych użytkowników internetu dotyczącym tego, dlaczego u nas wszystko rozpoczęło się tak późno. Rzeczywiście można zauważyć, że pod koniec lat 80. świat pędził już naprzód łącząc tysiące mniejszych lub większych sieci w jedną globalną pajęczynę, natomiast u nas nadal była pustynia.

Odpowiedź jest dość prosta i można ja streścić jednym skrótem – COCOM. Cóż to takiego? Po II wojnie światowej świat był podzielony na dwa główne bloki polityczne – umownie możemy je nazwać Wschodem (tutaj byliśmy my, a Wielkim Bratem był Związek Sowiecki) oraz Zachodem (pod przewodnictwem USA). Obie strony uczestniczyły w wyścigu o dominację militarną nad światem, a dość oczywiste jest to, że w takim wyścigu kluczową sprawą jest wysoka technologia.

Dlatego też w 1949 roku państwa zachodnie powołały instytucję zwana COCOM (akronim pochodzący od angielskiej nazwy Komitet Koordynacyjny Wielostronnej Kontroli Eksportu). Komitet ten decydował o tym, jakie nowoczesne urządzenia mają prawo być eksportowane do krajów bloku wschodniego. Rzecz jasna na liście urządzeń objętych embargiem była także zaawansowana technologia informatyczna – w tym duże komputery i oczywiście wszelkie urządzenia niezbędne do tworzenia rozległych sieci komputerowych.

Trzeba było wielu lat, aby doprowadzić do zniesienia restrykcji COCOM – dopiero po polskim przełomie roku 1989 formalnie zniesiono zakazy dotyczące eksportu technologii informatycznych i Polska mogła rozpocząć swoją drogę do sieci.

Jak zaczęliśmy doganiać świat

Koniec lat 80. był w zasadzie punktem zwrotnym w historii polskiej sieci. W ramach projektu NASK (Naukowa Akademicka Sieć Komputerowa) rozpoczęto łączenie komputerów w różnych ośrodkach akademickich.

Była to zdecydowanie faza eksperymentalna, ponieważ sprzęt, na którym działano zdecydowanie odbiegał od tego, czym dysponowała reszta świata. Oczywiście należy też dodać, że w tym momencie nasza sieć nie była w żaden sposób podłączona do ogólnej sieci europejskiej.

Wtedy jednak rozpoczęły się próby uzyskania dostępu do EARN (European Academic Research Network) – początkowo były to połączenia typu dial-up (wdzwaniane) z ośrodkami akademickimi w Danii i Szwajcarii. Były one wykonywane w nocy, ponieważ w dzień nie dało się w żaden sposób nawiązać rozsądnej transmisji ze względu na to, iż ówczesne modemy były bardzo prymitywne.

Formalnie Polska została podłączona do EARN w roku 1990, a 17 lipca tegoż roku został przesłany pierwszy legalny e-mail do Polski (Centrum Informatyki Uniwersytetu Warszawskiego) z duńskiego węzła sieci EARN. Musimy pamiętać, ze siec EARN nie pozwalała w owym czasie na zdalne łączenie się z odległymi komputerami, a jedynie na przesyłanie poczty elektronicznej oraz plików.

Również w 1990 roku ma miejsce bardzo istotne wydarzenie z punktu widzenia historii internetu w Polsce. Otóż 30 kwietnia tego roku zostaje zarejestrowana domena .pl. Co ciekawe, na początku jej obsługą zajmuje się Duńczyk (!) Jan Sorensen.

Pierwsze połączenia miedzy polskimi ośrodkami naukowymi miały miejsce w czerwcu 1991 roku (Warszawa-Kraków), natomiast za oficjalny początek internetu w Polsce uznaje się zwykle dzień 17 sierpnia 1991 roku, kiedy to nastąpiło pierwsze połączenie zagraniczne Warszawa-Kopenhaga.

W październiku tego samego roku nastąpiło uruchomienie już stabilnego łącza internetowego właśnie z Kopenhagą, a za jej pośrednictwem z całą Europą Zachodnią. Nadal jednak nie mieliśmy łączności z resztą świata (czytaj: USA), ponieważ łączność ze Stanami Zjednoczonymi była dla nas zablokowana po stronie amerykańskiej. Zielone światło zostało zapalone w dniu 15 grudnia 1991 roku, co tak naprawdę było dość dużą niespodzianką, albowiem nie nastąpiło żadne formalne porozumienie w tej sprawie. W tym momencie Polska była już prawowitym członkiem społeczności internetowej.

Strony anglojęzyczne:

- http://www.darpa.mil – strona projektu DARPA, tam narodziła się sieć!

- http://www.cybergeography.org/atlas/historical.html – atlas geografii historycznej internetu

- http://www.walthowe.com/navnet/history.html – krótka historia internetu

- http://www.zakon.org/robert/internet/timeline/ – ważne daty w historii sieci

- http://www.w3.org/People/Berners-Lee/FAQ.html#Examples – ciekawa strona Tima Berners-Lee zawierająca odpowiedzi na wiele pytań dotyczących m.in. historii internetu

- http://netvalley.com/intval1.html – bardzo interesująca historia z wieloma odnośnikami

- http://www.livinginternet.com – uporządkowany zbiór informacji o sieci

Strony polskie:

- http://kalendarium.icm.edu.pl – kalendarium polskiego internetu

- http://www.fuw.edu.pl/~ajduk/internet.html – tu zaczął się polski internet

- http://www.internet10.pl – strona na jubileusz 10-lecia sieci w Polsce

- http://www.internet10.pl/10lat.pdf – referat (w PDF) opisujący powstanie i rozwój internetu w Polsce (dużo materiałów źródłowych i dokumentów)

Warto zauważyć, że nasze pierwsze łącze z Danią miało przepustowość 9600 b/s (tak, tak… 9,6 kb/s), ale już po kilku miesiącach dorobiliśmy się łącza satelitarnego o gigantycznej (na owe czasy) prędkości 64 kb/s.

Od tego momentu wszystko zaczęło toczyć się znacznie żwawiej. Korzyścią późnego podłączenia do sieci było to, że mogliśmy uniknąć wielu błędów i ślepych uliczek, w które zapędzali się światowi pionierzy internetu.

Należy podkreślić, że na początku lat 90. dostęp do globalnej sieci był w zasadzie ograniczony do środowisk akademickich. Internet z założenia był niekomercyjny i ta zasada była naprawdę ścisłe przestrzegana. Dość szybko okazało się, że takiego stanu rzeczy nie da się utrzymać, co miało (i do dziś ma) konsekwencje zarówno negatywne, jak i pozytywne.

W 1992 pierwsza firma w Polsce (ATM) zaoferowała komercyjny dostęp do internetu. Oczywiście w owych czasach ceny były tak wysokie, że mogły z tego skorzystać wyłącznie firmy, i to raczej te bogatsze. W tym samym roku Telekomunikacja Polska uruchomiła sieć POLPAK (X.25) – było to preludium powszechnego dostępu do sieci.

W 1993 uruchomiono pierwszy polski serwer WWW – na Wydziale Fizyki Uniwersytetu Warszawskiego – zaledwie kilka miesięcy po udostępnieniu pierwszej \”prawdziwej\” przeglądarki stron WWW, słynnej NCSA Mosaic.

Kolejnym kamieniem milowym w rozwoju polskiego internetu było uruchomienie (czerwiec 1996) wdzwanianego publicznego dostępu do internetu przez TPSA – łezka się w oku kreci, gdy człowiek wspomni słynny numer 0-202 122 (kolejne łzy kręciły się w oczach co miesiąc, gdy przychodził rachunek telefoniczny). W grudniu tego samego roku uruchomiono pierwsze polskie wyszukiwarki – Sieciowid oraz Netoskop.

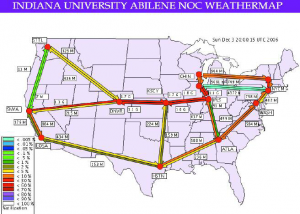

Początek 1997 roku to pokaz eksperymentalnego łącza o przepustowości 34 Mb/s, co w owym czasie plasowało nas naprawdę wysoko, jeśli chodzi o szybkość transferu miedzysieciowego. Dwa lata później jesteśmy już połączeni ze światem (a konkretnie z europejską siecią TEN-155) właśnie takim szybkim łączem o przepustowości 155 MB/s.

W tym momencie Polska nie rożni się już od innych państw europejskich zarówno jeśli chodzi o przepustowość sieci, jak też powszechny dostęp do internetu. Nadal problemem pozostaje rzecz jasna cena dostępu do sieci, która w wielu przypadkach ma ciągle charakter zaporowy. Miejmy jednak nadzieję, że i ten problem zostanie rozwiązany w niedługim czasie.

Co dalej? No cóż… Nawet łącza megabitowe powoli się zapychają, nadchodzi wielkimi krokami era gigabajtowa. Witamy więc w sieci Abilene i projekcie Internet 2. Na razie takie cuda techniki są testowane na uczelniach w USA, ale prędzej czy później pojawią się i u nas, czego Wam, drodzy Czytelnicy, i sobie życzę.