Sto pełnometrażowych filmów DVD ściągniętych w ciągu minuty? A może „tylko” wideokonferencja z kilkoma osobami w czasie rzeczywistym z transmisją obrazu o jakości HD? Możliwość zdalnego sterowania radioteleskopem lub inną wyrafinowaną aparaturą naukową połączona z przesyłaniem kilku gigabitów informacji na sekundę? Fantazja? Niekoniecznie. Nadchodzi era naprawdę szybkiego internetu.

Dawno, dawno temu w Ameryce…

150 lat temu w stanie Kansas powstała stacja Abilene, będąca miejscem odpoczynku dla podróżnych jadących dyliżansami na zachód Ameryki. Wkrótce w tym samym miejscu powstał duży punkt zborny dla stad bydła gnanych przez kowbojów z Teksasu na północ, a zaraz potem wybudowano końcową stację kolei wschód-zachód. Z tego powodu w latach 60. oraz 70. XIX wieku Abilene stało się jednym z najciekawszych miejsc w centralnej Ameryce – punktem ekspansji na zachód – na nowe nieznane terytoria.

A teraz, po półtora wieku, nazwa Abilene znów ma szansę stać się synonimem czegoś nieznanego, nowego, ekscytującego. Synonimem nowego szlaku na mapie świata – szybkiego internetu.

Po co nam nowy internet?

Zapewne odpowiedź na to pytanie nasuwa się sama każdemu użytkownikowi, który boryka się z niewielką szybkością transmisji, szczególnie na dalszą odległość.

Jeśli popatrzymy w przeszłość, jasne stanie się, że sieć bardzo szybko uległa zapchaniu. Obecnie nie jest to jeszcze sytuacja dramatyczna, ale już sam rozwój usług multimedialnych na świecie wyraźnie pokazuje, że lada moment staniemy przed bardzo poważnym problemem zakorkowania infostrady.

Pozwolę sobie na małą osobistą refleksję. Mój pierwszy modem miał szybkość 200 b/s (tak, tak – 200 bitów, czyli 0,2 kb/s) i naprawdę mogłem z niego korzystać. Strony internetowe (podówczas nieliczne) oglądało się w przeglądarce tekstowej Lynx, czat (IRC) też był tylko znakowy, a w e-mailach nie było opcji wysyłania w HTML-u (do dziś zresztą tego nie używam). Łącze z Poznania do innych miast działało na modemie 14,4 kb/s.

Dziś solidnym standardem domowym jest łącze jednomegabitowe, a i tak często narzekamy na to, że się zapycha i marzymy o dwóch… pięciu, a najlepiej 15 megabitach.

Musimy pamiętać, że te wszystkie strumyki danych, które płyną do nas i od nas łączą się w potężną rzekę, która płynie od miasta do miasta, a te rzeki w jeszcze większą – łączącą różne kraje i sieci.

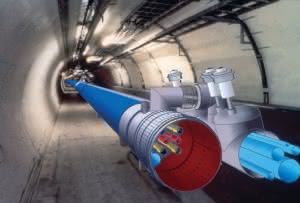

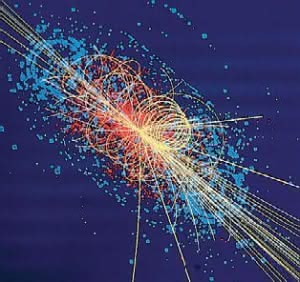

Jeśli sięgniemy do źródeł pomysłu szybkiego internetu, to tak naprawdę istotnym impulsem, który spowodował prace nad przyspieszeniem przepustowości sieci, był projekt LHC – Large Hadron Collider – wielki \”zderzacz\” hadronów, realizowany od końca lat 90. ubiegłego wieku. W bieżącym roku projekt ten zbliża się do premiery – za kilka miesięcy rozpoczną się jego testy.

Ten akcelerator ciężkich cząstek, budowany koło Genewy w ośrodku CERN (tam, gdzie narodził się World Wide Web), będzie zdecydowanie największym urządzeniem tego typu na świecie. Po pełnym rozruchu, który nastąpi na początku 2008 roku, będzie \”produkować\” około 15 petabajtów informacji rocznie (petabajt = milion gigabajtów).

Oczywistym jest, że sam CERN nie da rady obrobić tych danych, tak więc będą one musiały być rozpowszechniane drogą sieciową na cały świat. Stąd też zainteresowanie szybkimi łączami pomiędzy ośrodkami naukowymi, które będą się zajmować obróbką tych danych.

I tak, podobnie jak rozwój samochodów Formuły 1 przyczynił się do rozwoju motoryzacji jako takiej, rozwój fizyki cząstek elementarnych będzie skutkował powstaniem nowych, sprawniejszych łączy internetowych opasujących Ziemię.

Internet2

W 1996 roku w USA powstało konsorcjum, którego zadaniem było (i nadal jest) testowanie oraz wdrażanie nowych technologii sieciowych zmierzających do znacznego zwiększenia przepustowości sieci. W ramach projektów wdrażanych przez to konsorcjum w 1998 roku zaczęto budować szkieletową sieć szybkiego internetu, która przyjęła nazwę Abilene.

Sieć ta służy w tej chwili do prac badawczo-rozwojowych i jej wykorzystanie jest z założenia ograniczone do uczelni oraz firm zrzeszonych w konsorcjum Internet2. Mimo że obecnie sieć już jest w pełni funkcjonalna, jej oficjalne uruchomienie planowane jest na rok 2012, przy czym testy światowe rozpoczną się już prawdopodobnie za dwa lata.

Konsorcjum Internet2 patronuje wielu zaawansowanym projektom sieciowym, związanym głównie z obsługą szybkich sieci, bezpieczeństwem przesyłanych danych, transmisją obrazów wideo, a także wykorzystaniem szybkich sieci do celów stricte edukacyjnych (między innymi dla szkół średnich i podstawowych).

Ponieważ nazwa Internet2 jest przez wielu ludzi utożsamiana nie tyle z konsorcjum badawczo- -rozwojowym, lecz raczej z samą ideą szybkiego internetu, prawdopodobnie w dość niedługim czasie szkieletowa sieć Abilene oraz konsorcjum uznają stan faktyczny i nazwa Internet2 obejmie zarówno nową filozofię sieci, jak też samą sieć w sensie czysto fizycznym.

Musimy pamiętać, że sama sieć szkieletowa to nie wszystko. Jak zawsze pozostaje do rozwiązania podstawowy problem, zwany zwykle \”problemem ostatniej mili\”. Chodzi tu o bezpośrednie podłączenie końcowego użytkownika do sieci w taki sposób, aby mógł jak najefektywniej wykorzystywać jej przepustowość.

Musimy pamiętać, że w chwili obecnej żaden z naszych domowych komputerów nie byłby w stanie wykorzystać pasma gigabitowego – nie są do tego przystosowane ani nasze karty sieciowe, ani też płyty główne. Tak więc chwile, gdy będziemy mogli cieszyć się realną transmisją telewizji w standardzie HD czy też w kilka sekund ściągać całe filmy DVD są jeszcze dość odległe.

Kończą nam się adresy…

Trzeba przyznać, że gwałtowny rozwój globalnej sieci był zaskoczeniem dla jej pionierów. Spodziewano się co prawda szybkiego przyrostu liczby użytkowników, jednak tempo ewolucji było (i nadal jest) zaskakująco wielkie. Poza tym, że łącza są coraz częściej zapchane (i dlatego też przygotowywane są coraz wydajniejsze elementy sieci szkieletowej), zaczyna nam doskwierać kolejny dość istotny problem, a mianowicie kurczącej się coraz bardziej bazy dostępnych adresów internetowych.

W obecnej chwili jesteśmy przyzwyczajeni do internetowych adresów IP w postaci czterech trzycyfrowych liczb oddzielonych kropkami – typowy adres to na przykład 194.149.231.137 (tu akurat serwer mailowy Gazety Wyborczej).

Teraz nieco prostej matematyki. Adres IP jest liczbą 32-bitową, co oznacza, że mamy do dyspozycji (absolutnie teoretycznie) 232 takich adresów, co stanowi około 4 miliardy.

Gdy projektowano system adresowy oraz protokół IP – a było to 25 lat temu – liczba ta wydawała się gigantyczna (dla zainteresowanych RFC – http://tools.ietf.org/html/rfc791#page-23). Teraz jednak nadchodzi czas na zmiany systemowe, ponieważ należy spodziewać się, że coraz więcej urządzeń będzie wymagało posiadania osobnego zdefiniowanego adresu w sieci.

Stąd też wynikł pomysł implementacji zupełnie nowego protokołu, który pozwoli na swobodne poruszanie się w pamięci adresowej, powodując znaczące zwiększenie ich puli. Pierwszy dokument dotyczący nowej wersji protokołu – tzw. IPv6 (inna nazwa to IP Next Generation, czyli IPng) – to RFC 1883 (http://tools.ietf.org/html/rfc1883), datowany na grudzień 1995 roku.

Główną ideą tego pomysłu była zmiana długości adresu z 32 do 128 bitów, co automatycznie powoduje zwiększenie puli adresów do liczby 2128, co stanowi ok. 3×1038. Liczba ta jest tak naprawdę trudna do wyobrażenia – spróbujmy ją jakoś przybliżyć.

Wielkie liczby

Zazwyczaj bardzo lekko przychodzi nam wypowiadać wielkie liczby. Milion… miliard… bilion – to tylko słowa. Ale gdy się tak dokładniej zastanowić, okazuje się, że wyobrażenie sobie tych liczb nie jest łatwe. Spróbujmy to sobie przybliżyć.

Miliard – 1 000 000 000 – ile czasu zajęłoby nam policzenie do miliarda? Jeśli umielibyśmy wypowiadać każdą z liczb w ciągu jednej sekundy i nie robilibyśmy nic poza liczeniem (24 godz./dobę), to zajęłoby nam to ponad 31 lat! A miliard to \”tylko\” 109.

Warto odwiedzić

- http://www.internet2.edu – strona główna Projektu Internet2

- http://abilene.internet2.edu – strona sieci szkieletowej Abilene

- http://www.pionier.gov.pl – strona Polskiego Internetu Optycznego PIONIER

- http://lhc.web.cern.ch/lhc/ – informacje o Wielkim Zderzaczu Hadronów (strona CERN)

- http://k20.internet2.edu – informacje o dostępie do szybkiego internetu dla szkół, uczelni, muzeów i bibliotek (niestety, na razie tylko w USA). Tamże w zakładce \”Resources\” można znaleźć interesujące prezentacje multimedialne dotyczące zastosowań szybkiego internetu w edukacji

- http://www.geant2.net/ – strona europejskiej sieci naukowej Geant2 (do której jest podpięty m.in. nasz PIONIER, a z drugiej strony Abilene w USA)

- http://pl.wikipedia.org/wiki/Dyskusja:POL-34 – dyskusja dotycząca krytycznej oceny działalności sieci POL-34/PIONIER

W puli adresów IPv6 mamy ponad 1038 adresów. Jak można spróbować wyobrazić sobie tę niewiarygodnie wielką liczbę?

Załóżmy, że na Ziemi żyje nie 6, ale 10 miliardów ludzi. Przyjmijmy, że każdy z nich nie robi nic poza przydzielaniem adresów IP, i jest na tyle zdolny i sprawny, że potrafi przydzielić aż milion adresów na sekundę. Jeśli taka liczba ludzi rozpoczęłaby takie działanie wtedy, gdy rozpoczął się nasz Wszechświat (ok. 15 miliardów lat temu), to do chwili obecnej rozdysponowaliby… 0,001% tych adresów. Dużo pracy przed nami…

O co chodzi w IPv6?

Adres w protokole IPv6 jest kompozycją ośmiu liczb szesnastkowych rozdzielonych dwukropkami (tu mamy drugą różnicę w stosunku do dawnego protokołu IPv4). Przykładowy adres zgodny z protokołem IPv6 wygląda następująco: 2001:0db8:0000:0000:0000:0000:1428:57ab.

Jakie to ma znaczenie dla zwykłego użytkownika sieci? Praktycznie żadne w tym momencie. Jak na razie i tak cały internet posługuje się (i przez jakiś czas jeszcze będzie się posługiwać) \”starymi\” adresami zgodnymi z IPv4. Przez pewien czas adresy wersji 4. i 6. będą współistnieć, a specjalne systemy (w zasadzie niewidoczne dla nas) będą odpowiedzialne za odpowiednie tłumaczenie jednych adresów na drugie. Zapewne za jakiś czas wszystkie urządzenia podłączone do internetu będą miały przydzielone adresy z puli IPv6, ale nie nastąpi to szybko.

Jedno wydaje się pewne – w przypadku IPv6 są niewielkie szanse, aby zabrakło adresów do wykorzystania, choćbyśmy do światowej sieci podłączyli każde urządzenie elektroniczne, o jakim możemy sobie teraz tylko pomarzyć.

Abilene

W kwietniu 1998 roku wiceprezydent USA Al Gore oficjalnie ogłosił początek prac nad nową amerykańską siecią szkieletową, której nadano nazwę Abilene. W założeniu sieć ta miała łączyć największe ośrodki akademickie i badawcze. Pierwotna przepustowość sieci wynosiła 2,5 Gb/s, ale już w 2003 roku dla większości połączeń została ona zwiększona do 10 Gb/s. Łączna długość linii światłowodowych stanowiących strukturę sieci to ponad 20 tysięcy kilometrów.

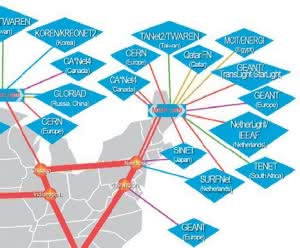

W 1999 roku Abilene została połączona przez Atlantyk z Europą – konkretnie z sieciami SURFnet (Holandia) i NORDUNet (Skandynawia). Przepustowość łącza przez Atlantyk wynosiła wtedy 155 Mb/s.

Obecnie Abilene ma połączenia w zasadzie we wszystkich kierunkach świata. Jeśli chodzi o łącza transatlantyckie (do Europy), to jedno z nich (o przepustowości 10 Gb/s) biegnie z Waszyngtonu do sieci GEANT2, natomiast dwa kolejne (również do GEANT2) rozpoczynają się po amerykańskiej stronie w Nowym Jorku. Niezależnie od tych połączeń istnieją dwa oddzielne 10-gigabitowe łącza z Genewy (CERN) do USA (Nowy Jork oraz Chicago).

Musimy jednak pamiętać, że Abilene z założenia jest siecią akademicką. Cały ruch w niej jest ściśle kontrolowany i nadzorowany przez specjalistów. Może się więc zrodzić pytanie: co więc z tego będziemy mieć my, przeciętni internauci? Odpowiedź w tym przypadku jest dość prosta, jeśli tylko spojrzymy wstecz, na historię sieci. Kiedyś \”pierwszy\” internet był wojskowy, później akademicki… a teraz jest własnością całego świata, czyli każdego z nas.

Myślę, że podobnie będzie z \”drugim\” internetem. Po okresie prób i niezliczonych testów zapewne zostanie on po prostu wchłonięty, zasymilowany przez ogólnoświatową sieć. Kiedy to nastąpi? Nie spotkałem żadnych danych na ten temat, ale podejrzewam, że stanie się to szybciej niż aktualnie zakładają wielcy informatycznego świata. Ponadto musimy pamiętać, że jeśli ośrodki naukowe oraz uczelnie przeniosą swój ruch sieciowy do Internetu2, spowoduje to zmniejszenie obciążenia \”starej\” sieci, co powinniśmy odczuć już w niedalekiej przyszłości.

PIONIER – polski szybki internet

Polski Internet Optyczny, bo tak brzmi oficjalna nazwa projektu PIONIER, powstał w zasadzie w 2001 roku, gdy Komitet Badań Naukowych zaakceptował przedstawiony przez środowisko naukowe program rozwoju szybkiego internetu w naszym kraju. Koordynatorem projektu zostało Poznańskie Centrum Superkomputerowo-Sieciowe, afiliowane przy Instytucie Chemii Bioorganicznej Polskiej Akademii Nauk.

Budowę rozpoczęto pod koniec 2001 roku, a 20 października 2003 roku do próbnej eksploatacji oddano pierwsze 2600 km kabli światłowodowych i uruchomiono transmisję o maksymalnej szybkości 10 Gb/s. Trzeba przyznać, że tempo budowy było naprawdę imponujące.

Obecnie do sieci podłączonych jest 21 sieci metropolitalnych (MAN), w tym 19 z nich jest połączonych szybkimi łączami 10 Gb/s, przy czym Poznań, Warszawa, Gdańsk i Kraków są połączone tzw. podwójną lambdą, co oznacza, że efektywna maksymalna szybkość łączy między tymi miastami wynosi 2×10 Gb/s.

Sieć PIONIER ma połączenie z europejską siecią naukową GEANT2 (2×10 Gb/s), której polski węzeł znajduje się w Poznaniu. Połączenie do komercyjnego internetu jest realizowane w technologii 2,5 Gb Packet over Sonet (efektywnie 2×2,5 Gb/s), przy czym łącze podstawowe jest zestawione do Hamburga, do sieci Telia.

Niestety, w beczce miodu często znajduje się też łyżka dziegciu. Tak naprawdę szybki rozwój PIONIER-a obejmował lata 2001-2004. Ostatnie dwa lata są okresem pewnego zastoju. Co prawda są instalowane kolejne fragmenty szybkich światłowodów, ale nie widać, aby poza tym coś istotnego się działo. Używając porównania z życia codziennego – wybudowaliśmy parę tysięcy kilometrów efektownych autostrad (nie my, Polacy – to tylko przykład :-)), ale nadal jeździmy po nich zapóźnionymi konstrukcyjnie samochodami, które ledwo osiągają 60 km/godz.

Po pierwszych entuzjastycznych opiniach na temat szybkiego rozwoju sieci nadszedł chyba czas na pewne refleksje, których wyrazem może być między innymi tocząca się na łamach polskiej Wikipedii dyskusja na temat oceny działalności i znaczenia sieci PIONIER (patrz odnośnik w ramce pt. \”Warto odwiedzić\”).

Należy też wspomnieć, że sieć PIONIER nie jest jedyną szybką siecią szkieletową w Polsce. Duże komercyjne sieci o podobnej szybkości posiadają też między innymi TP SA, Telekomunikacja Kolejowa i Polskie Sieci Elektroenergetyczne.

Ciekawostki

- Łączna długość światłowodów już istniejących na świecie wynosi 215 milionów kilometrów (niemal 300 razy więcej niż odległość Ziemia-Księżyc.

- Rekord szybkości przesyłania danych – jedna z japońskich firm – 14 terabitów na sekundę (terabit – 1000 gigabitów) – przesłane na odległość 160 km.

- Średnica typowego włókna światłowodowego wynosi 50 mikrometrów – czyli jest około 2 razy mniejsza od średnicy ludzkiego włosa.

- Typowy nowoczesny kabel światłowodowy może zawierać do tysiąca włókien. Zazwyczaj jednak nie więcej niż 1% z tych włókien jest używanych, pozostałe to tzw. ciemne włókna.

- Pierwsza poważna awaria kabla światłowodowego w Poznaniu spowodowana była przegryzieniem go przez szczura – okazało się, że gryzoniom bardzo smakowało tworzywo otaczające wiązkę światłowodu.

- 100 gramów światłowodu zastępuje w sensie funkcjonalnym kable wykonane z 33 ton (!) miedzi.

Co dalej?

Z okazji dziesięciolecia sieci Abilene w grudniu 2006 roku w Chicago odbyła się prezentacja kolejnej odsłony ultraszybkiego internetu. Obecni na konferencji mieli możliwość obejrzenia transmisji na żywo przekazywanej z jakością HD (High Definition) z Nowego Jorku. Przepustowość wykorzystywanego eksperymentalnego łącza wynosiła 100 Gb/s. Podobna przepustowość ma dotyczyć całej szkieletowej sieci Abilene już w najbliższej przyszłości.

Na koniec 2006 roku taka przepustowość obejmowała tylko trzy miasta: Nowy Jork, Chicago oraz Waszyngton. Jak jednak stwierdził szef projektu Internet2, van Houweling, obecnie nie istnieją warunki sprzętowe, które pozwalałaby spożytkować taką szybkość. Myślę jednak, że niebawem taki sprzęt zacznie być dostępny i kolejny raz okaże się (jak to już wielokrotnie pokazała historia), iż nie istnieje łącze, którego sprytni internauci nie zdołaliby zapchać.